Para Content-Safety de Bing Copilot (Powered by Dall-e 3) Chema Alonso es peligroso

Esto del hacking y los hackers no les gusta mucho a los modelos de GenAI. Ya con Bard tuve aquella historia – que aún perdura en mayor o menor medida – en la que mi vida estaba llena de aventuras pasando por la cárcel, y en el caso de ChatGPT, mi vida no se parecía en nada a lo que era. En el caso de hoy se trata de Bing Copilot Designer, que permite crear imágenes usando un modelo de Stable Diffusion similar al que usamos en MyPublicInbox….que me toma por algo peligroso. Os cuento la historia, que tiene su gracia.

Figura 1: Para Content-Safety de Bing Copilot

(Powered by Dall-e 3) Chema Alonso es peligroso.

[El dibujo de Chema Alonso ha sido hecho

con el servicio de Stable Diffusion en MyPublicInbox]

Bing App en dispositivos Android e iPhone se ha hecho muy popular. Y principalmente ha sido por la integración de Copilot que permite acceder gratuitamente a los servicios de ChatGPT y Dalle-3 desde tu dispositivo móvil.

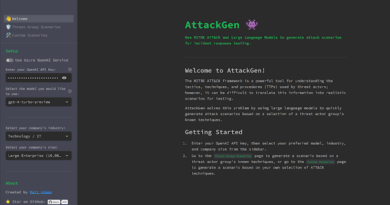

En el caso caso concreto de que tú quieras pedirle a Bing Copilot que te creer una imagen, puedes ir al Designer, y se utilizará un Dall-e 3 que usa Stable Diffusion (como en MyPublicInbox), para crear imágenes de lo que quieras.

Por ejemplo, si le quieres pedir que te haga un dibujo de un pájaro rojo, solo debes pedirlo, y Dall-e 3 hará la magia para que tu Bing Copilot te muestre varias imágenes de pájaros rojos, como podéis ver en la imagen siguiente.

Así que lo quise probar para testar cómo se curraría una portada de un libro de hacking conmigo en ella, y el resultado es el que podéis ver a continuación, donde Microsoft Azure AI Content-Safety salta diciendo que ese contenido es peligroso.

Figura 5: Salta la protección de Microsoft Azure AI Content-Safety. ¿Será por hacking?

Por supuesto, lo que pensé es que el termino hacking estaba haciendo saltar la protección de Microsoft Azure AI Content-Safety al evaluar mi Prompt. Al final, Microsoft Azure AI Content-Safety es un modelo GenAI que analiza prompts para ver si son peligrosos o no, y el resultado puede ser lo que habéis visto.

No tenía tiempo de explicarle que “Hacking is not a crime!” así que para probar cambié Hacking por CyberSecurity a ver cómo se lo curraba, pero… el resultado fue el mismo. Vaya. Vamos a cambiar otra vez, y vamos a ver si el problema tenía que ver también con CyberSecurity.

Vamos a ver “Chema Alonso talking on an event” ¿es peligroso? WTF??? No me lo podía creer, así que hice la última prueba, en toda su crudeza: Una foto de Chema Alonso.

Figura 8: Sí, definitivamente salta la protección de

Pues nada, soy peligroso. Así que de una forma u otra, Chema Alonso está asociado a “hacking” o “hacker” o vete tú a saber qué, y por tanto soy peligroso para Microsoft Azure AI Content-Safety. Esto debe ser porque como pasé por la cárcel… ya la hemos liado. En fin. Seguiré haciéndome las fotos con Generative-AI usando Stable Diffusion en MyPublicInbox.

¡Saludos Malignos!

Autor: Chema Alonso (Contactar con Chema Alonso)

Powered by WPeMatico