GhostBuster (& DetectGPT + GPTZero) para detectar un LLM usado como GhostWriter… o no.

Este mismo lunes se ha publicado el paper y la herramienta de GhostBuster, una nueva aproximación para detectar cuando un texto ha sido escrito or un modelo de Generative-AI basado en un LLM. Es decir, para saber cuándo un trabajo ha sido hecho con ChatGPT, o un escritor ha utilizado un LLM para hacer un artículo en una revista, un post en un blog, pero también pueden servir para detectar cuando ha aparecido un libro fraudulento falsificando a un escritor, se ha usado para correos de Spam, para conversaciones de Humanos Sintéticos, o comentarios automáticos en redes sociales. Quién sabe dónde nos llevará este mundo.

El paper, que se titula «GHOSTBUSTER: DETECTING TEXT GHOSTWRITTEN BY LARGE LANGUAGE MODELS«, lo tienes disponible en la red, y ha sido publicado por investigadores de la Universidad de California, Berkeley.

Como puedes leer en el paper, no es el primer estudio para detectar a los LLMs en los textos que se envían como propios, y continúa la línea de investigación de GPTZero y DetectGPT, que también puedes probar en la red.

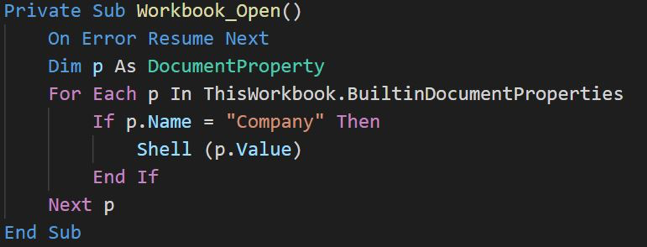

El modelo utiliza un clasificador lineal basado en un modelo entrenado con textos generados por diversos LLMs, y por humanos, utilizando funciones escalares y vectoriales para clasificar las características extraídas de los textos, que luego van a ser pasados por una regresión lineal. El paper detalla todo el proceso, y en su GitHub podéis ver el código completo, junto con los datasets utilizados.

Figura 4: GitHub de GhostBuster

Y como además tenemos demos online de GhostBuster, GPTZero y DetectGPT, pues he ido a hacer una sencilla prueba para ver cómo funciona con un par de textos. Uno que le he pedido directamente a ARIA, el LLM que viene con el Navegador Opera, y otro escrito por mí.

Una vez obtenido el texto, se lo pasamos a los tres detectores, y vemos qué resultados nos da, que son bastante curiosos. El primero de ellos, GhostBuster, que da una alta probabilidad de que sea IA-Generated, pero «sólo» al 70%.

Si vamos ahora a las soluciones previas – también son de este año, no penséis que son de hace mucho tiempo – nos dan unos resultados menos acertados. En el caso de GPTZero obtenemos que es un MIX entre Human-AI, lo que no es cierto, ya que es sólo LLM.

Es normal que este texto se le escape a GPTZero, que está pensado y entrenado con textos generados con ChatGPT y no como en el caso de GhostBuster que ha sido entrenado con textos de múltiples LLMs para no depender tanto de la forma de generar textos de un LLM entrenado de una manera concreta.

Figura 8: DetectGPT no es capaz de dar una respuesta

Probando DetectGPT,, no he sido capaz de conseguir una respuesta. No sé si por que la plataforma estaba saturada, o si realmente porque se queda en una estado de duda sobre el resultado a ofrecer. No obstante, he querido hacer algunas pruebas más, a ver cómo funcionaban las plataformas.

La primera de ellas ha sido probar un texto escrito por mí con GhostBuster a ver qué resultado ofrece. El texto lo he cogido de uno de mis artículos de «El futuro está por hackear«, donde me explayo más a la hora de escribir, que la web de Zenda Libros del gran Arturo Pérez-Reverte me impone respeto.

Os garantizo que no usé nada para escribir ese texto, pero aún así dice que hay un 27% de probabilidades. Y es que debo escribir muy «LLMeizado» en algunas partes. Pero tanto un 70% en el caso anterior donde sí usé un LLM como un 27% ahora que no, deja. un porcentaje grande para falsos positivos… aún. Tened en cuenta que está haciendo una «predicción» del resultado, y eso puede llevar a un suspenso de un trabajo, o al descrédito de un escritor ante sus compañeros de profesión. Y quedan muchas más preguntas sobre esto, así que volveré a hablaros de esto en otro artículo.

¡Saludos Malignos!

Autor: Chema Alonso (Contactar con Chema Alonso)

Powered by WPeMatico